研华正式发布国产化昇腾AI Box与Deepseek R1模型部署全流程!

随着深度求索(DeepSeek)大模型的发布引发行业热议,研华科技基于昇腾Atlas平台边缘AI Box MIC-ATL3S正式发布与Deepseek R1模型的部署流程。该平台依托昇腾芯片的强大异构计算能力,结合研华边缘AI Box高可靠特点,通过模型轻量化、算子适配等技术实现大模型边缘端部署。

硬件部署/

CPU:Atlas 310P

10个DaVinciV200 AI core,主频最高达1.08GHz

16个64位TaishanV200M处理器核,核主频最高1.9GHz

8个DaVinciV200 Vector core,主频最高达1GHz

内存:24G LPDDR4

AI算力:176TOPS INT8

操作系统:OpenEuler

模型:DeepSeek-R1

推理模型/

根据MIC-ATL3S硬件规格,我们选取了DeepSeek-R1-Distill-Qwen-1.5B这个精度和对硬件配置要求相对平衡的蒸馏模型进行适配和部署。

部署步骤/

昇腾310P + openEuler22.03部署deepseek-R1

1. 安装驱动包以及CANN

前往昇腾社区获当前芯片版本的驱动、FW、以及CANN(昇腾异构计算架构)

driver:Ascend-hdk-310p-npu-driver_xxxxx_linux-aarch64_chip-enable.runFirmware:Ascend-hdk-310p-npu-firmware_xxxxx_chip-enable.runCANN:Ascend-cann-toolkit_xxxxx_linux-aarch64.run

2. 安装依赖组件

3. 安装mindspore (昇思模型框架)

4. DeepSeek-R1模型拉取

拉取模型指令,以1.5B为例

yum install git-lfs -y

git lfs instal

lgit clone https://ai.gitee.com/hf-models/DeepSeek-R1-Distill-Qwen-1.5B

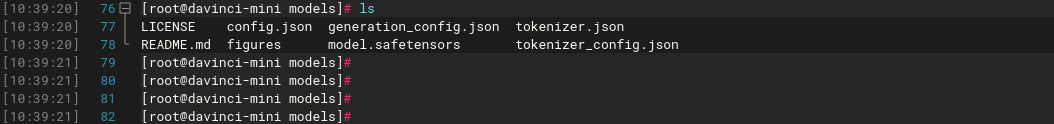

克隆完成示例如下,包含HF完整的仓库:

5. 模型转换

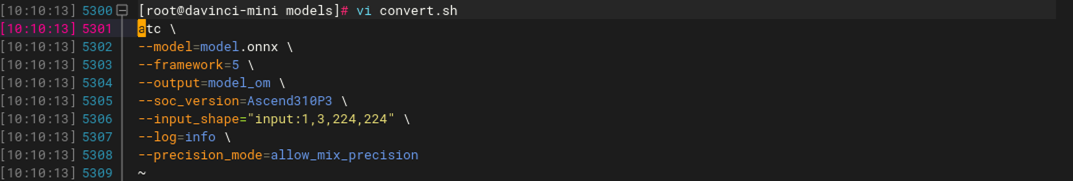

下载后的模型为safetensors格式,还不能直接使用,先用transformers转换为ONNX格式,再使用atc转换为OM(昇腾)格式才能使用。

创建python脚本将safetensors格式转换为ONNX格式,最终转换为OM格式。

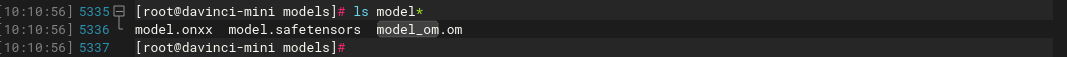

执行脚本后会生成对应模型文件,生成对应格式模型文件 执行:

Python3 convert.py

./convert.sh

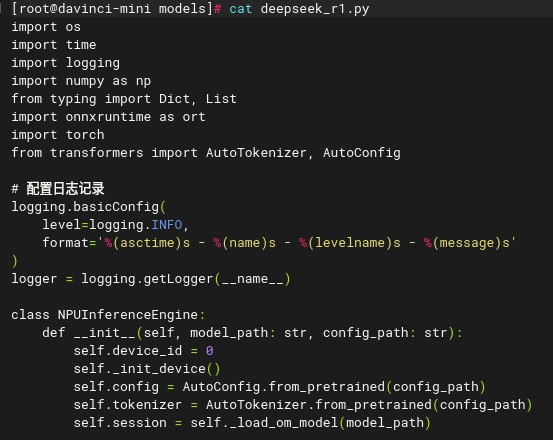

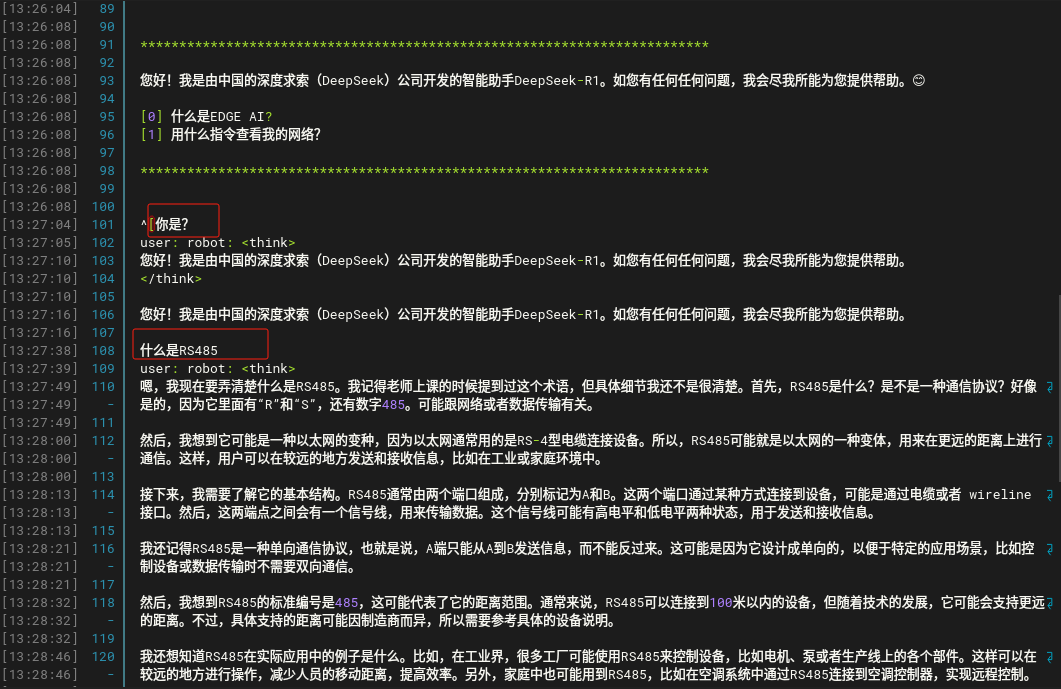

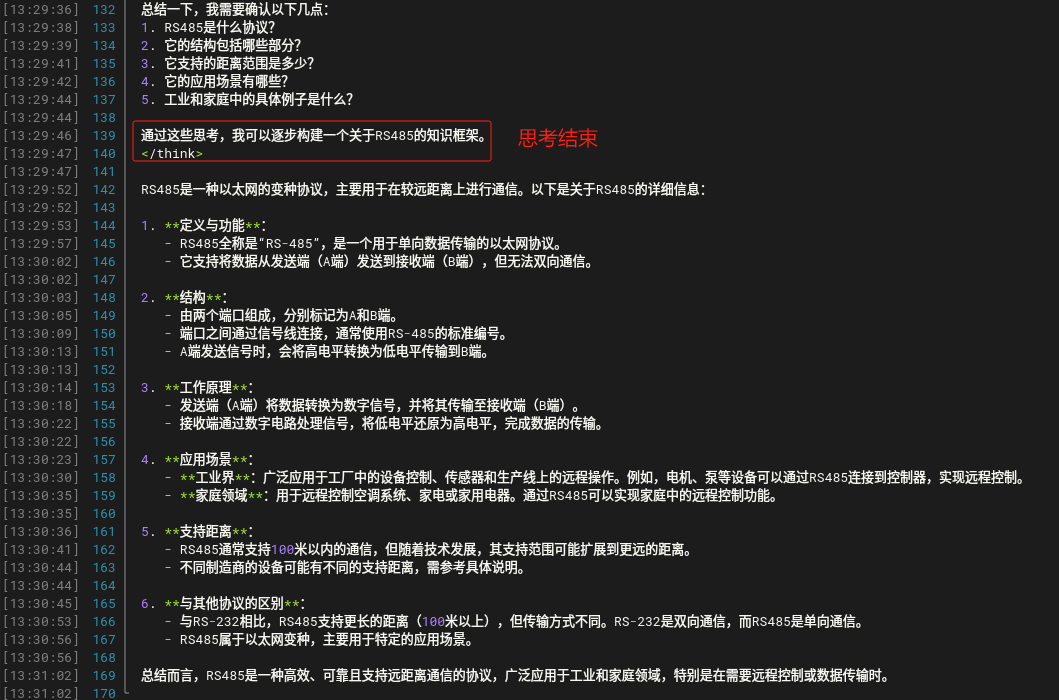

最后,需要用一个简单的python脚本去做互动窗口,运行指令:python3 deepseek_r1.py

示例:

总结:目前研华进行MIC-ATL3S适配更多Deepseek模型,以及与生态伙伴展开具体应用场景测试,后续我们会持续公布研华边缘AI平台产品的部署&测试内容,敬请关注。